El avance de la tecnología y de la inteligencia artificial ya es algo imparable, esto sumado a lo que puede brindar la visión computacional (Computer Vision), que se basa en sensores de movimiento, cámaras y la habilidad de sistemas para detectar y generar sonidos, son cosas que pueden dar resultados prometedores en un futuro cercano.

Pues bien, parece que el sentido del tacto en la robótica, nunca había tenido tanto avance como el de la actualidad. No podemos dar por sentado nada aun, y mucho menos asegurar algo.

Sin embargo, podemos decir que esta área y su investigación está tomando fuerza, tanto así que no es algo descabellado decir que pronto podremos ver a robots o humanoides andando con esta habilidad en campos específicos, como el arte, la agricultura o la telemedicina, por mencionar algunas actividades.

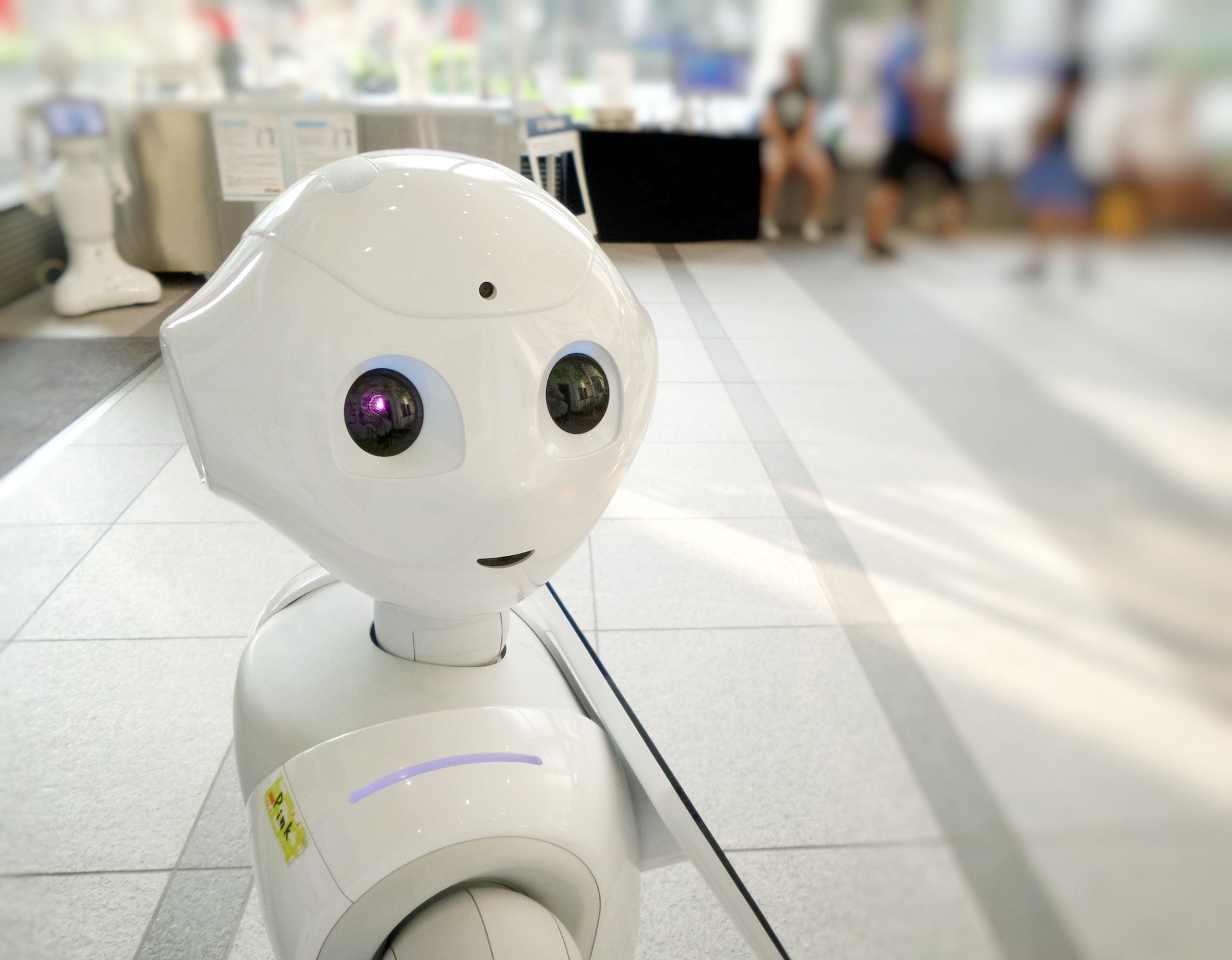

Se trata de el grupo de científicos del grupo Meta AI, quienes han trabajo por un largo periodo de meses en el hardware y el software correspondiente.

De hecho, han liberado el software como código abierto, para que así más científicos del mundo puedan aportar más, extenderlo y crear diferentes soluciones, con la posibilidad de integrar cualquier información recabada a sus propios sistemas de inteligencia artificial, y así poder darle a sus robots el sentido del tacto.

¿Cuáles son los avances que ofrece la tecnología en este campo?

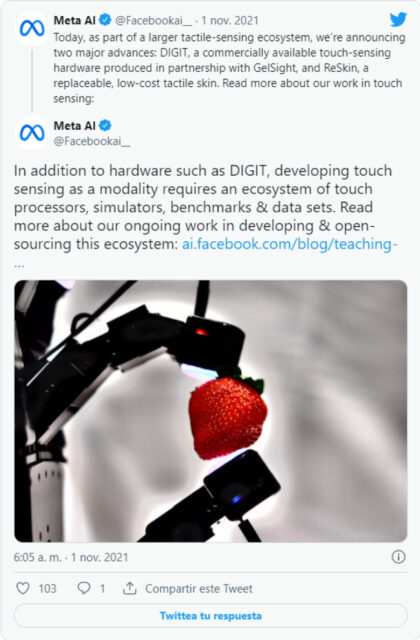

El año pasado fue lanzado un sensor, fabricado por DIGIT, el cual funciona con cámaras, pero ha resultado una opción positiva para investigación, pues su tamaño y facilidad de fabricación se convierte en algo “barato” de hacer.

Debido a que el código quedó abierto, surgió una empresa llamada GelSight, que es encargada de fabricarlos y venderlos para que cualquiera pueda tener acceso a ellos.

Existen más opciones para quienes quieran hacer pruebas antes de adquirir el sensor. Meta AI, ofrece un simulador muy completo que les ayudará con las investigación e implementación, y no solo eso, pues ofrecen una librería de software (el Frame de desarrollo) para poder lograrlo. La librería lleva por nombre PyTouch y también está liberada con código abierto.

También está la opción de la ReSkin la piel “sensorial”, por si no requieren una resolución alta, lo mejor de esta opción es que es muy versátil, escalable y de costo bajo. Todas estas opciones, tienen como objetivo que los investigadores tengan una buena variedad y puedan crear soluciones para ampliar el rango de tareas que puedan llevar a cabo sus robots en la vida real.

Twitter @Meta AI.

¿Porque Meta quiere darles la habilidad del tacto a los Robots?

Los demos realizados en manos y brazos mecánicos, muestran que pueden ser capaces de manipular cosas tan frágiles como un huevo o una uva, pero siempre manipulando el objeto con una delicadeza muy amplia, esto gracias al software y el sensor de entrenamiento de la tecnología machine learning.

Podría ser, que los robots fueran entrenados por doctores para poder realizar exámenes físicos y detectar algún tipo de anomalía. Se podrían implementar accesorios de realidad aumentada que sean capaces de recopilar información útil, en determinadas ocasiones.

Desde su cambio de nombre, la empresa ha estado muy focalizada en avanzar en todo lo que tenga que ver con realidad aumentada o dispositivos que nos sumerjan más en un mundo virtual, haciendo que podamos ver, sentir y escuchar todo, como si fuera la realidad.